Семантическое ядро яндекс директ. Семантическое ядро для контекстной рекламы: алгоритмы для разных типов кампаний Готовое семантическое ядро для директа

Соберем семантическое ядро для Яндекс Директа (для поисковых кампании и РСЯ)

Откуда будем брать ключевые слова? Каким должно быть семантическое ядро? Что с ним делать? Куда пихать, как разделять, что отправим в поисковую рекламную кампанию, а что в . Обо всем этом ниже.

Основы сбора семантического ядра для Директа

Перед сбором семантики уясним пару моментов (для тех, кто не знал), что для крутой и прибыльной рекламной кампании важен охват. Охват целевого, чистого трафика, разумеется. Для этого мы соберем как можно больше базовых масок ключей, пропарсим в Кейколлекторе (КК) и добавим некоторые фразы из специальных баз с ключевыми словами – ниже расскажу подробнее. Таким образом, у нас будет довольно полное семантическое ядро. Полнее, чем у 80% рекламодателей 🙂

Что такое базовые маски ключевых слов?

Это одно или два слова, которые описывают тематику (нишу) и на которых строится семантическое ядро для Яндекс Директ. Например, в Аренде спецтехники – «услуги спецтехники», «аренда спецтехники» – базовые маски, просто «спецтехника» – нет. Можете взять «спецтехнику» за базовую маску и пропарсить, но мусора будет много, нужных ключевых слов мало. Так же и в других сферах, в Отделке квартир – «ремонт квартир» – да, «квартира» – нет.

Расширяйте семантическое ядро транслитерацией

Транслитерация – пишем по-русски латиницей, например. Если, конечно, тематика предусматривает такие ключевики. Например, купить айфон – купить iphone, яндекс директ – yandex direct. Не применяйте транслитерацию на ровном месте, например – ремонт квартир – remont kvartir. Толку никакого не будет, такие запросы не вводят в поисковик, такая семантика будет пустой. Далее, пропарсив все в КК, увидите частотность и уберете пустые запросы, сделаете «рабочее» семантическое ядро для Директа.

Используйте синонимы при сборе семантики

Иногда мы не берем за базовую маску одиночное слово. Например, автомобиль, в тематике ремонт автомобиля. Появится столько мусора, что устанем минусовать мусор. В таком случае лучше поработать с синонимами (ремонт, отремонтировать, ремонтировать и тд.), чем создавать семантическое ядро через высокочастотные, мусорные однословники.

Где я ищу маски ключей и как расширяю семантическое ядро?

Сначала пишу из головы. И где нибудь на пятой маске (где–то тут фантазия часто заканчивается), пользуюсь следующей схемой:

1. Собираем маски из Wordstat. Иду в вордстат и вбиваю туда то, что написал из головы. После этого в вордстате открывается правая колонка (рисунок №1). В правой колонке вордстата показываются запросы, которые люди еще вводили и искали вместе с базовыми масками, которые я придумал вначале. По такой схеме, иногда я залипаю в вордстате на час, переходя по правым колонкам. Все маски ключей из вордстата я добавляю в Yandex Wordstat Assistant (рисунок №2) (YWA – расширение для Хрома, Яндекса, Оперы). YWA быстро формирует список из базовых масок и выделяет уже добавленные фразы при переключении по колонкам вордстата. Проще говоря, через YWA можно быстро накидать список масок из вордстата, не покинув браузера.

В правой колонке вордстата тоже можно найти базовые маски

Пробегаю по правым колонкам и собираю маски в YWA

2. Просматриваем поисковики. Перебираю маски ключей на выдачу в поисковых системах. Вбиваю фразы в поисковики и смотрю дискрипшены (рисунок №3) и смотрю Яндекс и Google картинки (рисунок №4) (там часто нахожу много нового).

Смотрим выдачу в Яндексе и Google

Просматриваем картинки в Яндекс и Google картинкам

3. SpyWords. Далее, сформированный список масок (по желанию) отправляем в SpyWords (SW). Если пользуетесь Кейколлектором (если нет – странно), то можно из него спарсить выдачу SW. SW прибавит масок ключей и синонимов. Будет много мусора, парсите SW в отдельную группу, заберете нужные маски, а группу удалите потом.

4. Парсим в Кейколлекторе. Теперь беру все маски ключей и заливаю в Кейколлектор. Чаще, 1 маску ключей помещаю в отдельную группу. 1 маска = 1 группа (рисунок №5). Так привык и такой подход не раз выручал. Если вдруг по какой–нибудь одной маске спарсите пару тысяч шлака, можно легко удалить шлаковую группу. А если парсить все маски в одну группу, будет весело. Либо заново все парсить, либо сидеть и судорожно вычищать мусор.

Вот так выглядит уже пропарсенное и очищенное семантическое ядро

5. Пропарсили маски в КК. Парсим подсказки. Я рекомендую собирать подсказки в отдельную группу (т.к. много мусора) и по опыту – выбирайте подсказки Yandex и Mail.ru. Если очень хочется – еще Google, но в отдельную группу его, там еще больше мусора, чем в подсказках Яндекса и Майл.ру.

6. Чистим ключи. На этом этапе чищу ключевые слова от мусора. О чистке, минусации слов написал .

7. Добираем ключи из баз. Затем идем и добираем фразы из специальных баз. Самые популярные (вроде) – База пастухова, MOAB, Букварикс. Рекомендую использовать Букварикс. На сколько знаю, в Буквариксе меньше «мусора» и пока еще бесплатный. Сделайте для них отдельную группу в КК и парсите, потом отминусуете ненужные ключи.

Все, семантическое ядро собрано и очищено. Осталось разгруппировать.

Семантика для Яндекс Директа отличается в поисковой кампании и кампании для РСЯ

Семантическое ядро для РСЯ

На данном этапе (пока ничего не разгруппировано), удобнее сделать семантику для РСЯ. Фильтруете в КК базовую частоту больше 50 запросов и забираете ключевые слова для настройки РСЯ. Семантику с частотностью меньше 50 в месяц нет смысла брать в РСЯ. Трафика с таких ключевых слов вы вряд ли получите. Раньше я фильтровал ключи для РСЯ еще по количеству слов (3 и меньше). Забил, когда увидел, что и 4-5 словники конвертят.

Семантическое ядро для поисковых рекламных кампаний Директа

Тут я беру семантику (уже очищенную от мусора), удаляю пустые ключевые слова, с нулевой частотностью и делаю группировку. Группировка ключевиков – второй по важности момент в семантике для Директа, после сбора масок ключей.

Для чего нужна группировка ключевых слов?

Группировка ключевиков стала более актуальной в Директе с приходом статуса «Мало показов» , когда все низкочастотные группы ключевых перестали участвовать в аукционе. И поэтому сейчас группировка семантики важна еще тем, что просто нужно сохранить охват в Директе. Группировку ключевых слов мы делаем для большей эффективности рекламных кампаний. Чтобы сделать цену клика немного пониже, из-за хорошего CTR. В конечно счете, чтобы получать больше звонков, заказов при том же бюджете (понятно, что не один Директ влияет на цену заявки).

Самая распространенная группировка ключей – деление семантического ядра на горячие, теплые, холодные ключевые слова.

По факту – холодные ключи, это обычно околоцелевые и конвертят они чуть хуже, чем никак. Чтобы там ни говорили продавцы шашлыков (или септиков?) кто в теме, тот понимает о чем я 🙂 У кого конвертят – молодцы.

Я делаю семантическое ядро на горячие и теплые ключи для поисковой рекламы Директа

«Горячесть» ключей для каждой тематике своя.

Горячие ключевые слова:

В товарах – это приставки «купить», «цена», «доставка», какие то точные характеристики товара, принадлежность товара к какому то гео. Например «кирпич саратов», «кирпич купить» и тд.

В услугах – «заказать», «заказ», «под ключ», так же принадлежность к гео. Например, «заказать портрет а4 карандаш», «ремонт квартиры под ключ» и тд.

Теплые ключевые слова – это слова, в которых нет явного намерения приобрести, заказать товары (услуги), но это слова из нашей тематики и очень вероятно, что по ним будут конверсии. Например, «силикатный кирпич», «кладка кирпича», «портрет карандаш» и тд. Понятно, что ключевые слова мы корректируем минус словами и часто «теплые ключевые слова» конвертируют не хуже «горячих».

Я бы сказал, что это условное разделение. Чтобы на разгруппированную семантику потом релевантные объявления написать и анализировать проще, когда каждая группа объявлений подписана и мы знаем какие там ключи внутри.

Этой информации достаточно, чтобы собрать хорошее семантическое ядро для Директа (при условии, что Excel и Кейколлектор у вас есть).

Пишите в комменты или по контактам, если какие–то моменты непонятны.

Семантическое ядро - это перечень поисковых запросов, описывающих ваш товар или услугу, по которым пользователи будут видеть ваше объявление.

От того, насколько точно вы определите ключевые слова, будет зависеть, как часто и в какой очередности поисковик будет показывать ваше объявление в результатах. Поэтому полное семантическое ядро для можно считать одним из ключевых факторов успеха вашей рекламной кампании. Кроме этого семантическое ядро используют и для решения других задач.

Для чего нужно составлять семантическое ядро?

- Чтобы получить больше поискового трафика для вашего объявления.

- Чтобы собрать максимальное количество запросов, в том числе и низкочастотных, цена за клик по которым может быть намного ниже.

- Чтобы создать новый сайт.

- Чтобы изменить структуру уже существующего сайта, создав новые посадочные страницы.

Как составить семантическое ядро для контекстной рекламы?

- Выделение масок.

Начать работу над составлением тематического ядра нужно с подбора масок, т.е. определения главных ключевых слов, которые наиболее точно характеризуют ваш товар или услугу. Например, для рекламной кампании корпусной мебели маской будет «корпусная мебель».

- Подбор ключевых слов

Для каждой маски нужно подобрать поисковые запросы. Можно попробовать сделать это вручную, добавляя к каждой маске слова, описывающие ваш товар. Это могут быть действия, которые являются целью вашей рекламной кампании (купить, заказать и т.д.), названия брендов и характеристики товара. Упростит задачу использование специальных сервисов, таких как: Яндекс.Вордстат. Если задать маску, например, «корпусная мебель», то программа выдаст статистику запросов на Яндексе, в состав которых входит это слово.

Есть и другие сервисы: планировщик ключевых слов от Google, программа Слово*б, Key Collector и т.п.

- Дополнение списка синонимами и ассоциативными словами

Чтобы с одной стороны расширить диапазон показа объявлений, а с другой уменьшить бюджет, стоит дополнить список ключевых слов синонимами, транслитерацией, если ваш товар ищут по англоязычному названию, ассоциативными выражениями и ошибками. Ведь стоимость клика на такие слова будет меньше, а это значит, что уменьшится ваша средняя цена за клик.

- Чистка семантического ядра

На этом этапе нужно исключить из списка ключевых слов все неэффективные. Сначала стоит удалить те, которые не соответствуют целевым страницам и те, частотность которых близка к нулю. Затем еще раз перепроверить все остальные. Нужно определить реальную частотность слов и фраз. Это можно сделать в Яндекс.Вордстат, воспользовавшись следующей формулой ввода: «!слово». Например, фраза «квартира ипотека» имеет базовую частотность 111 623, а реальную всего 39.

- Учет минус-слов

Указывать минус-слова нужно для того, чтобы исключить показ объявлений по пересекающимся запросам и тем самым использовать свой бюджет рационально. ЯндексДирект, например, показывает объявления по широкому соответствую. Это значит, что, если будет задан запрос «летние платья» то система автоматически покажет объявления по запросам «летние платья красные», «летние платья оптом» и «летние платья из хлопка». Но если вы не продаете платья оптом, и в вашем ассортименте нет красных платье, то вам нет смысла показывать свое объявление по этим запросам. Так вы только напрасно потратите свой бюджет. Чтобы этого не случилось нужно задать минус-слова: «-оптом», «-красные».

Какие слова лучше использовать: с низкой или с высокой частотностью?

Мнение о том, что рекламная кампания будет эффективной только при использовании ключевых слов с высокой частотностью, не соответствует действительности. По ключевым словам с высокой частотностью всегда будет большая конкуренция и высокая цена за клик. В тоже время слова с низкой частотностью могут приносить хороший трафик. Поэтому использование тех или иных слов будет зависеть от того, какую цель вы преследуете:

- Если у вас ограниченный бюджет, то стоит начать рекламную кампанию со слов с низкой частотностью, которые приносят больше конверсий.

- Если для вас важны не конверсии, а максимальный охват аудитории и при этом у вас неограниченный бюджет, используйте ключевые слова с высокой частотностью.

В любом случае вы можете следить за ходом своей рекламной кампании и корректировать список ключевых слов в зависимости от их эффективности.

Разработка семантического ядра для контекстной рекламы - процесс довольно кропотливый. Но это того стоит. Правильно составленное семантическое ядро сделает вашу рекламную кампанию эффективной. Поэтому не стоит недооценивать его значимость и, если вы сами не имеете необходимых умений и навыков, стоит обратиться к специалистам.

О том, что важно учесть при составлении семантического ядра.

В закладки

Как собрать правильное семантическое ядро

Если вы думаете, что собрать правильное ядро способен некий сервис или программа, то вы будете разочарованы. Единственный сервис, способный собрать правильную семантику, весит около полутора килограмм и потребляет около 20 ватт мощности. Это мозг.

Причем в этом случае у мозга есть вполне конкретное практическое применение вместо абстрактных формул. В статье я покажу редко обсуждаемые этапы процесса сбора семантики, которые невозможно автоматизировать.

Существует два подхода к сбору семантики

Подход первый (идеальный):

- Вы продаете заборы и их монтаж в Москве и Московской области.

- Вам нужны заявки из контекстной рекламы.

- Вы собираете всю семантику (расширенные фразы) по запросу «заборы» откуда угодно: от WordStat до поисковых подсказок.

- Получаете много запросов - десятки тысяч.

- Затем несколько месяцев чистите их от мусора и получаете две группы: «нужные» запросы и «минус-слова».

Плюсы: в этом случае вы получаете 100% охват - вы взяли все реальные запросы с трафиком по главному запросу «заборы» и выбрали оттуда всё, что вам нужно: от элементарного «заборы купить» до неочевидного «установка бетонных парапетов на забор цена».

Минусы: прошло два месяца, а вы только закончили работать с запросами.

Подход второй (механический):

Бизнес-школы, тренеры и агентства по контексту долго думали, что с этим делать. С одной стороны, действительно проработать весь массив по запросу «заборы» они не могут - это дорого, трудозатратно, людей не получится научить этому самостоятельно. С другой стороны, деньги учеников и клиентов тоже надо как-то забрать.

Так было придумано решение: берем запрос «заборы», умножаем на «цены», «купить» и «монтаж» - и вперед. Ничего не надо парсить, чистить и собирать, главное - перемножить запросы в «скрипте-перемножалке». При этом возникающие проблемы мало кого волновали:

- Все придумывают плюс-минус одинаковые перемножения, поэтому запросы вида «монтаж заборов» или «заборы купить» моментально «перегреваются».

- Тысячи качественных запросов вида «заборы из профнастила в Долгопрудном» вообще не попадут в семантическое ядро.

Подход с перемножениями себя полностью исчерпал: наступают трудные времена, победителями выйдут только те компании, которые смогут для себя решить проблему качественной обработки действительно большого реального семантического ядра - от подбора базисов до очистки, кластеризации и создания контента для сайтов.

Задача этой статьи - научить читателя не только подбирать правильную семантику, но и соблюдать баланс между трудозатратностью, размером ядра и личной эффективностью.

Что такое базис и как искать запросы

Для начала договоримся о терминологии. Базис - это некий общий запрос. Если вернуться к примеру выше, вы продаете любые заборы, значит, «заборы» - главный для вас базис. Если же вы продаете только заборы из профнастила, то вашим главным базисом будет «заборы из профнастила».

Но если вы один, запросов много, а кампании надо запускать, то можно взять в качестве базиса «заборы из профнастила цена» или «заборы из профнастила купить». Функционально базис служит не столько как рекламный запрос, сколько как основа для сбора расширений.

Например, по запросу «заборы » более 1,3 млн показов в месяц по РФ

Это - не пользователи, не клики и не запросы. Это количество показов рекламных блоков «Яндекса» по всем запросам, включающим слово «заборы». Это мера охвата, применимая к некоему большому массиву запросов, объединенных вхождением в него слова «заборы».

О том, что важно учесть при составлении семантического ядра.

В закладки

Как собрать правильное семантическое ядро

Если вы думаете, что собрать правильное ядро способен некий сервис или программа, то вы будете разочарованы. Единственный сервис, способный собрать правильную семантику, весит около полутора килограмм и потребляет около 20 ватт мощности. Это мозг.

Причем в этом случае у мозга есть вполне конкретное практическое применение вместо абстрактных формул. В статье я покажу редко обсуждаемые этапы процесса сбора семантики, которые невозможно автоматизировать.

Существует два подхода к сбору семантики

Подход первый (идеальный):

- Вы продаете заборы и их монтаж в Москве и Московской области.

- Вам нужны заявки из контекстной рекламы.

- Вы собираете всю семантику (расширенные фразы) по запросу «заборы» откуда угодно: от WordStat до поисковых подсказок.

- Получаете много запросов - десятки тысяч.

- Затем несколько месяцев чистите их от мусора и получаете две группы: «нужные» запросы и «минус-слова».

Плюсы: в этом случае вы получаете 100% охват - вы взяли все реальные запросы с трафиком по главному запросу «заборы» и выбрали оттуда всё, что вам нужно: от элементарного «заборы купить» до неочевидного «установка бетонных парапетов на забор цена».

Минусы: прошло два месяца, а вы только закончили работать с запросами.

Подход второй (механический):

Бизнес-школы, тренеры и агентства по контексту долго думали, что с этим делать. С одной стороны, действительно проработать весь массив по запросу «заборы» они не могут - это дорого, трудозатратно, людей не получится научить этому самостоятельно. С другой стороны, деньги учеников и клиентов тоже надо как-то забрать.

Так было придумано решение: берем запрос «заборы», умножаем на «цены», «купить» и «монтаж» - и вперед. Ничего не надо парсить, чистить и собирать, главное - перемножить запросы в «скрипте-перемножалке». При этом возникающие проблемы мало кого волновали:

- Все придумывают плюс-минус одинаковые перемножения, поэтому запросы вида «монтаж заборов» или «заборы купить» моментально «перегреваются».

- Тысячи качественных запросов вида «заборы из профнастила в Долгопрудном» вообще не попадут в семантическое ядро.

Подход с перемножениями себя полностью исчерпал: наступают трудные времена, победителями выйдут только те компании, которые смогут для себя решить проблему качественной обработки действительно большого реального семантического ядра - от подбора базисов до очистки, кластеризации и создания контента для сайтов.

Задача этой статьи - научить читателя не только подбирать правильную семантику, но и соблюдать баланс между трудозатратностью, размером ядра и личной эффективностью.

Что такое базис и как искать запросы

Для начала договоримся о терминологии. Базис - это некий общий запрос. Если вернуться к примеру выше, вы продаете любые заборы, значит, «заборы» - главный для вас базис. Если же вы продаете только заборы из профнастила, то вашим главным базисом будет «заборы из профнастила».

Но если вы один, запросов много, а кампании надо запускать, то можно взять в качестве базиса «заборы из профнастила цена» или «заборы из профнастила купить». Функционально базис служит не столько как рекламный запрос, сколько как основа для сбора расширений.

Например, по запросу «заборы » более 1,3 млн показов в месяц по РФ

Это - не пользователи, не клики и не запросы. Это количество показов рекламных блоков «Яндекса» по всем запросам, включающим слово «заборы». Это мера охвата, применимая к некоему большому массиву запросов, объединенных вхождением в него слова «заборы».

Собрав полное семантическое ядро, вы всегда получите конкурентное преимущество за счёт большего охвата аудитории и, следовательно, больше заказов, покупок, лидов.

В этой публикации я постарался изложить весь процесс начального сбора ключевых фраз — сервисы, программы, принципы поиска и работы с полученными данными. А так же, описан способ составления базового списка минус слов (на основе собранного семантического ядра), который исключит 95% всех не целевых показов!

Способ сбора универсальный и подойдёт не только для рекламной кампании в Яндекс Директ, но и для формирования полноценной семантики для поискового продвижения (SEO). Одно лишь отличие — собирая семантическое ядро для контекстной рекламы, обычно не уходят так глубоко в НЧ фразы. А методы фильтрации и составления списка минус слов — одинаковый.

1-ый шаг. Сбор маркерных слов для парсинга в Яндекс WordStat

Статью пишу на основе одной из последних моих работ — лыжное снаряжение, техника катания и т.д.

Для поиска маркерных слов используем:

- Сам сайт, его разделы с товарами или услугами;

- Сайты конкурентов. Анализируем внешне по разделам и услугам, так и с помощью сервисов — megaindex, key.so и тому подобных;

- Сервисы синонимов;

- Правая и левая колонка в Яндекс WordStat, блок «с этой фразой ищут» под поисковой выдачей.

Маркерные слова/словосочетания — это только направления для дальнейшего изучения, «копания» вглубь, так сказать . Если в список уже добавили фразу — «выбор лыж», то не надо добавлять вложенную «выбор горных лыж». Все вложенные фразы будут найдены после парсинга в Key Collector.

Главная задача — собрать максимум маркерных слов (направлений), проверить синонимы, сленговые слова и сформировать общий список, по которому будем «копать» дальше.

Формировать удобно в визуальном виде, к примеру в и выглядит вот так:

На скриншоте открыта только одна ветка, чтобы изображение было вменяемого размера.

Огромная польза от такой визуализации, лично для меня, что если раскрыть все направления, сразу понимаешь, что многозадачность надо выключать и работать только с одним разделом, а не сразу со всеми. А то с последовательностью действий иногда возникают проблемы.

Важно : Для быстрой обработки и сохранения ключевых слов в Wordstat, попробуйте бесплатное расширение для браузеров — Yandex Wordstat Assistant . С помощью него можно быстро переносить необходимые ключевые фразы в семантическое ядро.

Таблица с вопросами удобна для больших проектов. Не знаю, как её назвать профессионально, но через такие вопросы, можно существенно расширить семантическое ядро, найти новые интенты, о существовании которых даже не подозревал в начале.

Собранные фразы перемножаются, а затем проверяются на частотность в Wordstat. Частотные фразы добавляются для дальнейшего изучения.

Интент — это то, ради чего пользователь вводит запрос в поисковую систему. Можно сказать его «боль». Набор из ключевых фраз может объединяться по одному интенту, то есть быть вызванным одним мотивом, хотя при этом написание и набор слов могут различаться.

Надо ли платные сервисы и программы для сбора семантического ядра?

Я использую программу Кей коллектор и все ниже описанные действия провожу в нём. Если её нет, то собрать полное ядро вряд ли получится. Вы сможете, конечно, вручную «походить» по Wordstat, расширение Wordstat Assistant в этом сильно поможет, взять ещё фразы из бесплатных баз, вроде Букварикса. Но это всё будет малая часть того, что действительно можно собрать.

В некоторых ситуациях этого достаточно, хотя я сторонник создания максимально полной семантики, особенно если тематика сайта небольшая и тематического трафика мало. В таких случаях целесообразно собрать всё, чтобы максимально охватить свою нишу.

Если у вас один сайт, то выгоднее будет заказать услугу сбора семантического ядра на аутсорсе. Заплатите 3-5 тысяч рублей, но получите полное ядро с максимум ключевых фраз, без необходимости покупать софт, оплачивать сервисы и так далее.

Для Яндекс Директ ключевые фразы в Key Collector собираю редко, только когда большие рекламные кампании, много направлений... Для маленьких и средних ниш достаточно Wordstat и проработка синонимов.

Чаще всего директологи плохо разбираются в объекте рекламы, и если вы рекламируете ваш товар/услугу, то вы априори подберете правильные ключевые фразы и лучшие объявления, которые затронут необходимые струны вашей целевой аудитории. Вам только надо разобраться в некоторых тонкостях и последовательностях работы. Что я и постараюсь подробно описать в этом цикле статей.

2-ой шаг. Сбор ключевых фраз в Яндекс WordStat

Собранные маркерные слова пропускаем через левую колонку Wordstat в Key Collector.

Для экономии времени большие направления можно разбивать вот так ёлочкой:

Больше семи слова WordStat не показывает, поэтому в подобных запросах только семи словный шаблон.

Вордстат даёт возможность просмотреть только 2000 вложенных фраз. Это 40 страниц. Если пролистаете к 40-ой странице по фразе «лыжи», то увидите, что список заканчивается на выражении с частотностью 62 показа. Для полного семантического ядра этого будет мало, так как дальше ещё может быть несколько сотен низкочастотных фраз, которые могут приносить дополнительный трафик.

Метод «елочкой» позволит сократить время и не проводить повторную итерацию парсинга полученных ключевых фраз после первого сбора. Key Collector возьмёт все фразы с Wordstat по данному маркерному слову, вплоть до частотности в 1, не ограничиваясь стандартными двумя тысячами.

Сбор ключевых фраз конкурентов и базы

Используем сервис megaindex, key.so или serpstat.com. Желательно проработать 5-10 прямых конкурентов. Из бесплатных баз, могу посоветовать .

Наблюдение: если первоначально хорошо проработаны маркерные слова, синонимы, сленговые выражения, то Wordstat даёт 70-80% поисковых запросов, а оставшиеся добираются от конкурентов и букварикса.

Эти фразы не стоит мешать со всеми, а добавлять лучше в отдельную группу в кей коллекторе.

Обратите внимание, чтобы при добавлении стояла галочка «Не добавлять фразу, если она есть в любой другой группе»:

Этим ограничением недопустим добавление дублирующих фраз в общее семантическое ядро.

Букварикс — отдельная история. Очень много неявных дублей, запросы различаются только перестановкой слов. Находит много фраз, но 70-80% из них не подойдут нам. Добавляю в отдельную группу, но не вычищаю и не работаю с ней, а только ищу интересующие меня фразы поиском, чтобы посмотреть, можно ли чем дополнить основную семантику с него или нет.

Сбор поисковых подсказок

Как только собрали все фразы в WordStat и конкурентов, следует объединить их в мульти-группы , отсортировать по базовой частотности (обычно от 100, либо от 50 если ниша небольшая) и выбрать целевые фразы для сбора поисковых подсказок по ним:

GIF

Вторая итерация сбора фраз для семантического ядра

На данном этапе собрано почти всё :). Для полноценного ядра требуется заглянуть ещё глубже и посмотреть вложенные фразы для найденных фраз в ходе вышеописанных действий.

Для фраз, собранных методом «ёлочки» не надо проводить повторную итерацию сбора, а вот для запросов найденных у конкурентов, выбранных в буквариксе и поисковых подсказок — стоит.

Для повторной итерации я сортирую собранные фразы по базовой частотности и выбираю целевые (так как мы ещё не чистили стоп словами, не стоит выделять всё подряд) до значения частотности в 100 единиц. Заново запускаю по ним пакетный сбор из левой колонки Yandex WordStat .

Важно: не мешайте все повторные сборы вместе, создавайте отдельные группы для конкурентов, букварикса, основному ядра собранному по маркерным словам, парсинг по второй итерации и так далее. Чем подробнее вы раздробите в моменте сбора семантики, тем проще её будет чистить от нецелевых фраз. Объединить всегда успеете!

3-ий шаг. Удаляем нецелевые фразы

На данном этапе надо удалить явно не целевые запросы. Проделать это можно с помощью универсальных стоп-слов. Я собираю их в этом файле на Google Docs ..

Делим все слова на: целевые / нецелевые / сомневаюсь

Этот шаг нужен для создания общего списка минус фраз, который можно использовать сразу на всю рекламную кампанию и для чистки всей семантики от нецелевых поисковых запросов.

На выходе получаем список из целевых и стоп слов с помощью которых мы будем чистить и проверять семантическое ядро.

Я сторонник параноидального способа 🙂 , который занимает много времени, но способен исключить 95% всех не целевых ключевых фраз.

По опыту скажу, чем качественнее проработан список минус слов и фраз, тем меньше в Яндекс Директ проскакивают не целевые показы и показы по синонимам, которые так любит добавлять поисковик для кампаний новичков, которые не уделяют должного внимания этой процессу.

У вас будет чистейший трафик, так как мы все уникальные слова в семантике проверили в ручном режиме и определили их принадлежность.

Алгоритм действий:

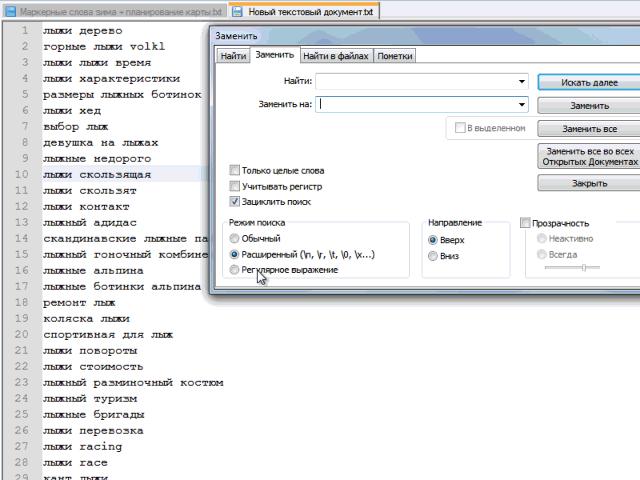

1. Выгружаем весь список ключевых фраз в notepad.

2. Превращаем фразы в список слов. Их будет много, если брать мой пример с семантикой под лыжи, то около 60 тысяч.

Пример автоматической замены пробела на «перенос строки» в notepad:

GIF

Этот шаг некоторые делают в Word, еще какими-то программными средствами. Я для себя выбрал блокнот notepad . Главный плюс — минимум действий для получения желаемого результата.

3. Копируем все слова в Excel и удаляем дубли:

После удаления дублей, остаётся около 15-20% слов от общего количества.

Получен список всех уникальных слов в нашей семантике. Далее каждое слово я прохожу с вопросом: целевое / не целевое / сомневаюсь . У слов, которые явно целевые, ставлю 1 в соседней ячейке, у сомневающегося 2, у минус слов ничего не ставлю, так как их будет больше всего.

Все сомневающиеся слова проверяю на конкретных поисковых фразах в семантическом ядре (быстрый поиск кей коллектора).

На выходе получаем список целевых слов и минус-слов. После чего, можно отдохнуть и попробовать осмыслить весь процесс и понять описываемую последовательность.

Резюмирую статью

Использую слово итерация, чтобы были понятны проделываемые действия. А то слово «сбор» общее и легко запутаться, особенно новичку.

Сейчас вот задумался. Наверно зря я объединил описание процесса сбора семантики для SEO и Директа. По большому счёту, второй шаг c углублённым сбором абсолютно всех фраз, для контекста не нужен. Нам нужные только ВЧ и СЧ фразы (частотность от 100 и выше, но зависит от тематики) и самые целевые НЧ.

В любом случае, пункты под номером 1 и 3 абсолютно одинаковы для обоих видов работ.

В следующих публикациях мы начнём группировать и сегментировать ключевые фразы, а так же вычищать семантику от не целевых фраз, неявных дублей и всего того мусора, которого примерно 70-80% от собранного на данном этапе.

Подписывайтесь на обновления блога в